Bonjour,

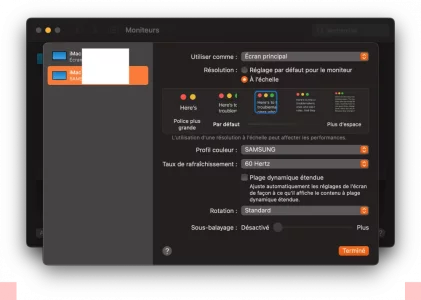

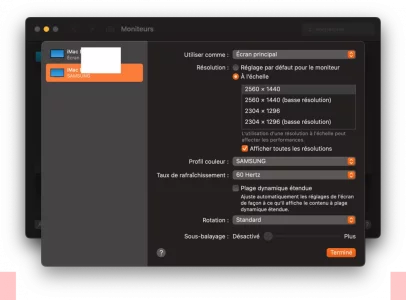

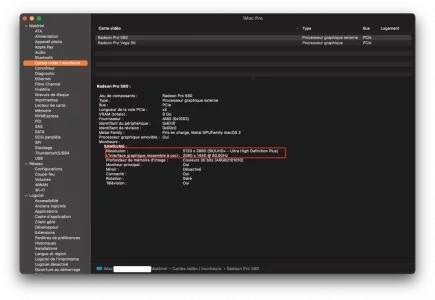

Question courte: «Pour de la programmation et de la bureautique, pour un même espace de travail, par exemple 2560x1440 sur 27", vaut-il mieux un écran 2k sans lissage ou bien un écran 4k lissé à @1.5?».

Réflexion ayant amené à la question :

:

Il y a eu sur MacG et ailleurs sur le web, dans la dernière année, plusieurs longues enfilades concernant les écrans ainsi que plusieurs analyses (promotions?) sur Youtube. On y lit/entend souvent que (je résume): «une dalle 4k lissée à @1.2 (ou @1.5) n'offrira évidemment pas le rendu d'un lissage @2k, mais c'est mieux que pas de lissage du tout».

Lorsque je fais le test avec mon «vieil» écran LG FHD, en le passant en 1600x900 - ce qui correspond à un lissage de @1.2 comparativement à sa définition native 1920x1080 - c'est flou; très (!) flou. Bien que les caractères soient plus gros, je trouve le texte beaucoup moins lisible.

J'ai aussi fait le test avec un lissage @1.5 (1280x720) et c'est, là aussi, très flou.

Est-ce que ce sera le même effet (le flou sera-t-il le même) avec n'importe quelle dalle ou y a-t-il différentes façons de lisser à un même taux de @1.5 (ou 1.2), ou d'autres paramètres à considérer (juste pour ce qui est de la netteté des caractères)?

J'imagine que oui, sinon il n'y aurait pas 200$ de différence dans le prix des modèles 278CV (2K) et 279CV (4K) de la gamme ProArt de chez Asus (sur papier, il me semble que la définition est la seule différence entre ces deux écrans). Sinon, si les caractères sont plus flous sur le 4k, quel est son intérêt?

Vos éclairages/avis/opinions/observations/commentaires/rétroactions/ (j'oublie quelque chose? ) seraient très appréciés.

) seraient très appréciés.

Question courte: «Pour de la programmation et de la bureautique, pour un même espace de travail, par exemple 2560x1440 sur 27", vaut-il mieux un écran 2k sans lissage ou bien un écran 4k lissé à @1.5?».

Réflexion ayant amené à la question

Il y a eu sur MacG et ailleurs sur le web, dans la dernière année, plusieurs longues enfilades concernant les écrans ainsi que plusieurs analyses (promotions?) sur Youtube. On y lit/entend souvent que (je résume): «une dalle 4k lissée à @1.2 (ou @1.5) n'offrira évidemment pas le rendu d'un lissage @2k, mais c'est mieux que pas de lissage du tout».

Lorsque je fais le test avec mon «vieil» écran LG FHD, en le passant en 1600x900 - ce qui correspond à un lissage de @1.2 comparativement à sa définition native 1920x1080 - c'est flou; très (!) flou. Bien que les caractères soient plus gros, je trouve le texte beaucoup moins lisible.

J'ai aussi fait le test avec un lissage @1.5 (1280x720) et c'est, là aussi, très flou.

Est-ce que ce sera le même effet (le flou sera-t-il le même) avec n'importe quelle dalle ou y a-t-il différentes façons de lisser à un même taux de @1.5 (ou 1.2), ou d'autres paramètres à considérer (juste pour ce qui est de la netteté des caractères)?

J'imagine que oui, sinon il n'y aurait pas 200$ de différence dans le prix des modèles 278CV (2K) et 279CV (4K) de la gamme ProArt de chez Asus (sur papier, il me semble que la définition est la seule différence entre ces deux écrans). Sinon, si les caractères sont plus flous sur le 4k, quel est son intérêt?

Vos éclairages/avis/opinions/observations/commentaires/rétroactions/ (j'oublie quelque chose?

Dernière édition: