[/QUOTE]

Mwouais !

On est déjà tellement envahi de toutes ces "oeuvres" (

) manipulées à l'extrême que l'art "brut" de la photographie disparaîtra au fil du temps !

Les Cartier-Bresson et Doisneau doivent se retourner dans leurs tombes !

Vous aurez compris que toutes ces techniques découlant de l'IA me laissent totalement indifférent !

Mais vous me direz que l'avis d'un "dinosaure" nostalgique vous importe peu et vous aurez raison !

En fait ils le faisaient faire tout autant.

Dans les expositions, c'est la mode de montrer les coulisses. Je me souviens d'une photo de Doisneau ou Ronis publié dans un journal des années 30. On avait une belle fontaine avec 3 gamins qui jouaient autour. Et puis à côté, il y avait les 3 photos originales qui avaient été utilisées pour fabriquer la photo finale.

Pour HCB, ils sont taquins dans les expos ; Le Grand Monsieur à "inventer" (au MOMA) le fait de laisser les bords de la pellicule sur le tirage grand format pour montrer que ce n'était pas recadré, que le cadrage était fait dans "l'instant décisif" (Ké Crâneur !). Du coup, ils ne peuvent pas s'empêcher de montrer l'originale de "Derrière la gare St Lazard", une de ses icônes : Il y a une barre noire à gauche ; il a pris la photo à travers une grille en oubliant qu'il utilisait un télémétrique — parce que photographier avec le ventre (Rolleiflex), c'est vulgaire (Quel emmerdeur !).

La photo a toujours été une construction. "You don't take a photograph, you make it" (Ansel Adams). C'était obligatoire au début ; on ne pouvait pas avoir le ciel et le sol ; il fallait choisir. Au tout début, ils peignaient le ciel et puis très vite, ils ont fusionné 2 photos (l'une exposée pour le ciel, l'autre pour le sol) avant de réussir à faire monter le ciel sous l'agrandisseur, les pellicules étant capables d'enregistrer de grands écarts de luminosité (on le fait encore aujourd'hui, sauf sur les smartphones qui le font eux-mêmes sans rien nous demander ; en revenant au montage de plusieur photos mais en coulisse).

En plus de réduire le temps de travail et le nombre de personnes impliquées, Photoshop et Midjourney ne font que rendre publique, grand publique, le fait que la photo, comme toute image, est une manipulation (pas que sous Staline).

"ils le faisaient faire", car il y avait tout une chaîne de compétence à l'époque. Le photographe qui travaillait pour la presse déclenchait, transmettait sa pellicule au journal et découvrait ses images dans la parution suivante. Les photos étaient développées par un spécialiste du développement qui faisait un tirage contact. Le responsable photo du journal choisissait les images sur les contacts pour tel ou tel article avec le responsable de la rédaction. Ces images étaient tirées par un tireur (Grade, Dodge & Burn, etc.). En général elles étaient repiquées (enlever les poussières et autres pets) et retouchées (enlever un bouton sur le visage, une tache sur la robe) par une personne spécialisée et parfois montées (plusieurs photos pour en faire une), toujours recadrées (le photographe veillait à prendre de la marge et le constructeur d'appareil photo l'y contraignait souvent).

@SirDeck a posté quelques compositions Midjourney sur le fil

côté cuisine

C'était la version précédente. Ça s'est bien amélioré.

Ça s'est déjà bien amélioré. Ma boîte me demande de faire de tests, pas plus de 2 jours. Je ferais ça fin août.

La génération d'images repose sur des données existantes. Le résultat est mécaniquement une idée reçue, un pastiche. Si on cherche à faire quelque chose de nouveau, la génération d'image est très intéressante pour bien voir ce qu'il ne faut pas faire. Il est intéressant d'utiliser les IA génératives pour se diriger à l'opposé de ce qu’elle propose. Mais surtout, c'est bien pratique pour débroussailler, tester des idées en restant vague. C'est très rapide de faire très imprécis. Mais reproduire l'image que l'on a dans la tête, c'est trèèèèèèèès difficile pour ne pas dire impossible, même pour un Prompt engineer. C'est pourquoi, il est possible de faire travailler la machine à partir d'une esquisse que l'on aura faite au préalable, même si on est loin de ce que l'on a en tête.

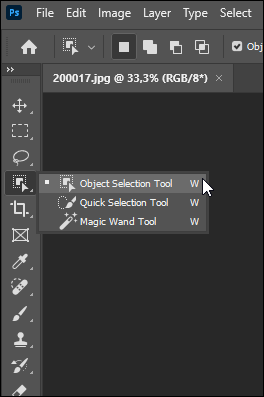

Pour en revenir à Photoshop, la mise en œuvre des technologies en provenance de l'IA est très maline. Elle s'appuie sur une des clefs de voûte du logiciel : la sélection. On sélectionne une zone et on lui demande d'y faire un truc. On ajoute alors des calques de réglage pour fondre la modification dans l'image. Mais justement, c'est surtout l'utilisation des avancées liées au champ de recherche IA pour faciliter des tâches de base sur photoshop qui sont spectaculaires. La sélection a encore fait un bond. La sélection de sujets est mise en avant. Il est possible de choisir de déporter le processus de sélection sur les processeurs d'Adobe (cloud computing) pour un résultat encore plus précis. le module "sélectionner et masquer" permet d'orienter le travail de la machine soit avec un simple bouton "améliorer les cheveux" (ouf !) ou avec un nouveau pinceau "amélioration des contours". La version actuelle permet également la sélection automatique du ciel ; on l'a dit plus haut, c'est un classique historique, à la limite de l'hommage aux premiers photographes.( Rien à voir, mais j'adore la minipalette qui s'ouvre à côté de la zone de travail pour donner un accès rapide aux options pertinentes ; retour à la base IHM ; loi de Fitts, tout ça)

Dans la version Bêta en cours, on a donc la grande entrée du prompt, façon génération de contenu. J'ai installé la bêta que pour ça ; comme je le disais je devais mettre une culotte à un bébé pour passer une censure et c'est vrai que ça a été très rapide avec un prompt. Mais c'est encore sur la sélection que ça ma mis une claque sur cette bêta ! On a l'outil "sélection d'objets" (et donc reconnaissance) qui débarque. La reconnaissance du ciel, des sujets, c'est pour les faibles. Là, c'est tous les objets. On finit toujours avec le module "sélectionner et masquer" pour affiner, finaliser. Un autre gros saut se trouve sur une tâche historique : la suppression d'un élément. Staline se chargeait d'éliminer dans le monde réel et les artisans devaient éliminer des textes et des images (ils ont inspiré le héros de 1984 d'Orwell). Donc là tu as un nouvel outil qui s'appelle… "supprimer" (un hommage à Staline sans doute) et qui vient s'ajouter aux outils de correction. Le résultat, instantané, est très impressionnant. Bien sûr, on doit finir à la main pour que ce soit invisible. On peut d'ailleurs utiliser le bon vieux tampon pour ça, celui-là même que l'on utilisait pendant des heures pour supprimer un objet…

Bref, Adobe à l'intelligence d'utiliser les avancées informatiques pour faciliter des tâches qui ont toujours existé. Le prompt chez eux, semble aller dans ce sens. Il est le pendant du nouvel outil "supprimer" (ce que j'ai sélectionné) : "Ajoute [un truc]" ( là où j'ai sélectionné).

C'était pour faire court. J'explique la suite en cuisine…

J'déconne !